Table of Contents

Web scraping là gì?

Web scraping, web harvesting, or web data extraction là việc thu thập dữ liệu được sử dụng để trích xuất dữ liệu từ các trang web. Phần mềm web scraping có thể truy cập trực tiếp vào Web bằng Giao thức HTTP hoặc thông qua trình duyệt web.

Mặc dù người dùng phần mềm có thể thực hiện việc quét web theo cách thủ công, nhưng thuật ngữ này thường đề cập đến các quy trình tự động được thực hiện bằng cách sử dụng bot hoặc trình thu thập thông tin web. Đây là một hình thức sao chép, trong đó dữ liệu cụ thể được thu thập và sao chép từ web, thường vào cơ sở dữ liệu cục bộ trung tâm hoặc bảng tính, để truy xuất hoặc phân tích sau này.

Nếu bạn đã từng sao chép và dán thông tin từ một trang web, bạn đã thực hiện chức năng tương tự như bất kỳ công cụ quét web nào, chỉ ở quy mô nhỏ, thủ công.

Web scraping, còn được gọi là data extraction, là quá trình truy xuất hoặc “loại bỏ” dữ liệu từ một trang web. Không giống như quy trình lấy dữ liệu theo cách thủ công, tốn nhiều thời gian, công sức việc web scraping sử dụng tính năng tự động hóa thông minh để truy xuất hàng trăm, hàng triệu hoặc thậm chí hàng tỷ điểm dữ liệu từ biên giới dường như vô tận của Internet.

Proxy là gi?

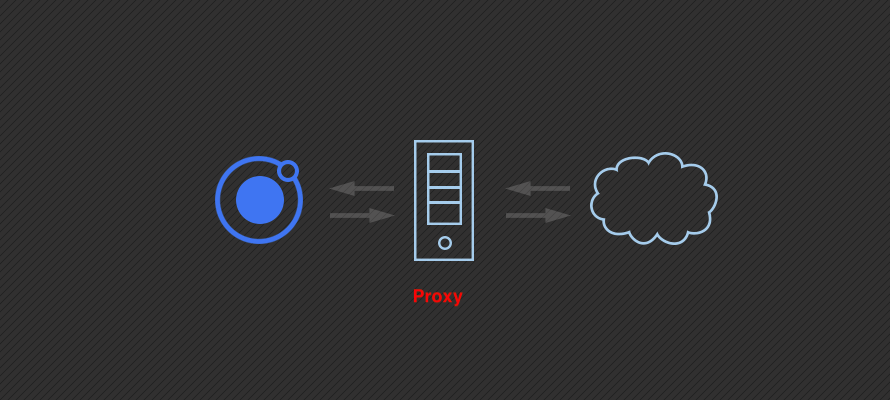

Proxy là một máy chủ của bên thứ 3 cho phép bạn định tuyến yêu cầu của mình thông qua các máy chủ của họ và sử dụng địa chỉ IP của họ trong quá trình này. Khi sử dụng proxy, trang web mà bạn đang thực hiện yêu cầu sẽ không còn thấy địa chỉ IP của bạn nữa mà là địa chỉ IP của proxy, cho phép bạn quét web ẩn danh nếu bạn chọn.

Tại sao cần proxy khi scraping?

Có một số lý do tại sao proxy lại quan trọng đối với việc quét web:

- Sử dụng proxy (đặc biệt là một nhóm proxy – sẽ nói thêm về điều này sau) cho phép bạn thu thập dữ liệu trang web một cách đáng tin cậy hơn nhiều. Giảm đáng kể khả năng chương trình của bạn bị cấm hoặc bị chặn.

- Sử dụng proxy cho phép bạn thực hiện yêu cầu của mình từ một khu vực địa lý hoặc thiết bị cụ thể (ví dụ: IP di động) cho phép bạn xem nội dung cụ thể mà trang web hiển thị cho vị trí hoặc thiết bị nhất định đó. Điều này cực kỳ có giá trị khi thu thập dữ liệu sản phẩm từ các nhà bán lẻ trực tuyến.

- Sử dụng nhóm proxy cho phép bạn thực hiện một lượng yêu cầu cao hơn đến một trang web mục tiêu mà không bị cấm.

- Sử dụng proxy cho phép bạn vượt qua các lệnh cấm IP hàng loạt mà một số trang web áp đặt. Ví dụ: các trang web thường chặn các yêu cầu từ AWS vì có hồ sơ theo dõi một số tác nhân độc hại làm quá tải các trang web có khối lượng lớn yêu cầu sử dụng máy chủ AWS.

- Sử dụng proxy cho phép bạn tạo các phiên đồng thời không giới hạn đến các trang web giống nhau hoặc khác nhau.

Proxy nào là tốt nhất cho việc scraping?

Khi nói đến proxy để tìm kiếm web, bạn cần biết rằng những proxy tốt nhất là những proxy hoạt động trên trang web mục tiêu của bạn. Điều này là do mỗi trang web có hệ thống chống spam & chống cắt xén độc nhất và những gì hoạt động trên Twitter có thể không hoạt động trên YouTube. Tuy nhiên, chúng tôi vẫn có thể đạt được thỏa thuận tốt nhất vì có một số nhà cung cấp proxy có proxy tương thích với hầu hết các trang web phức tạp.

Đối với mình, nhà cung cấp proxy tốt nhất mà tôi chọn là Bright Data. Họ cung cấp các loại proxy khác nhau: Datacenter, Static residential, Residential, Mobile. Nó rất dễ dàng và linh hoạt để sử dụng.

Tổng kết

Proxy rất quan trọng cho web scraping vì chúng giải quyết vấn đề cấm IP và truy cập nội dung web được nhắm mục tiêu địa lý. Tuy nhiên, không phải tất cả proxy đều hoạt động cho tất cả các trang web. Tùy thuộc vào yêu cầu dự án, ngân sách và kinh nghiệm mà chúng ta có thể chọn proxy hoặc API proxy.

Trong bài tiếp theo, chúng ta sẽ tìm hiểu sự khác nhau giữa các loại proxy: Datacenter, Static residential, Residential, Mobile

Mình là một lập trình viên tự do với hơn 10 năm kinh nghiệm. Mình chuyên về Web scraping, Web automation, Python, Django